ROBOTS ASESINOS DESOBEDIENTES.

“Me temo que no puedo hacer eso”: ¿Debería permitirse que los robots asesinos desobedezcan órdenes?

Por Arthur Holland Michel | 6 de agosto de 2024

A menudo se dice que las armas autónomas podrían ayudar a minimizar los horrores innecesarios de la guerra. Sus algoritmos de visión podrían ser mejores que los humanos a la hora de distinguir una escuela de un depósito de armas. No se dejarán influir por las furias que llevan a las almas mortales a cometer atrocidades; no masacrarán ni saquearán. Algunos especialistas en ética han sostenido durante mucho tiempo que los robots incluso podrían estar programados para seguir las leyes de la guerra con coherencia matemática.

Y, sin embargo, para que las máquinas traduzcan estas virtudes en la protección eficaz de los civiles en zonas de guerra, también deben poseer una capacidad clave: deben poder decir no.

Considere este escenario. Un dron autónomo enviado para destruir un vehículo enemigo detecta mujeres y niños cerca. En la retaguardia de las líneas enemigas, sin contacto con su operador, la máquina tiene que tomar una decisión por sí sola. Para evitar una tragedia, debe cancelar su propia misión. En otras palabras, debe rechazar la orden.

En teoría, la “rechazo del robot” suena razonable. Una de las objeciones de Amnistía Internacional a las armas autónomas es que “no pueden… rechazar una orden ilegal”, lo que implica que deberían poder rechazar órdenes. Sin embargo, en la práctica, plantea un dilema complicado. El control humano es el núcleo de la propuesta de los gobiernos en favor de una IA militar responsable. Dar a las máquinas el poder de rechazar órdenes iría en contra de ese principio. Mientras tanto, las mismas deficiencias que obstaculizan la capacidad de la IA para ejecutar fielmente las órdenes de un humano podrían hacer que se equivoquen al rechazar una orden.

Por lo tanto, los militares tendrán que demostrar que es posible construir armas autónomas éticas y responsables que no digan que no, o demostrar que pueden diseñar un derecho a rechazar seguro y fiable que sea compatible con el principio de mantener siempre a un humano “al tanto”.

Si no pueden hacer ni lo uno ni lo otro, o encontrar una tercera salida al dilema, sus promesas de robots asesinos éticos y a la vez controlables deberían tomarse con cautela.

El año pasado, 54 países, incluidos Estados Unidos, Reino Unido y Alemania, firmaron una declaración política en la que insistían en que las armas autónomas y la inteligencia artificial militar siempre operarían dentro de una cadena humana responsable de mando y control. Es decir, las armas autónomas actuarían únicamente y estrictamente bajo las órdenes directas de sus supervisores humanos. Otros, como la Federación Rusa, han subrayado de manera similar que las armas autónomas deben poseer la capacidad de discriminar entre objetivos legales e ilegales. Y, sin embargo, si las máquinas pueden superar a los humanos como expertos morales, como afirma un estudio reciente (y varios estados), tendrán dificultades para aplicar esa experiencia si solo pueden llegar a un acuerdo con sus usuarios humanos.

RELACIONADO:

Entrevista: Rose Gottemoeller sobre el precario futuro del control de armas

Permitir que una máquina diga "No lo haré" cuando se le presente una orden reduciría drásticamente esa autoridad. Daría a las máquinas un poder de decisión final que ningún estado cedería a una computadora. Podría ser posible ordenar a un arma que evite herir a civiles mientras obedece sus otras órdenes. Pero esto implica que se harán juicios legales sobre cuestiones como la proporcionalidad y la discriminación; sin embargo, el Comité Internacional de la Cruz Roja, entre otros, sostiene que sólo los humanos pueden hacer juicios legales porque sólo los humanos pueden ser considerados legalmente responsables de los daños.

En resumen, la idea de armas autónomas que se nieguen a obedecer órdenes sería imposible. Los ejércitos quieren máquinas que actúen como extensiones de su voluntad, no como un contrapeso a su intención. Incluso los países que se rigen por los más altos estándares legales (estándares que se basan en que todos los soldados estén facultados para decir no cuando se les da una mala orden) probablemente se opondrían a la propuesta. Mientras tanto, los ejércitos que pretenden violar deliberadamente la ley no querrán máquinas que cumplan rígidamente con ella.

Por lo tanto, los robots asesinos que los países probablemente utilicen sólo serán tan éticos como sus comandantes humanos imperfectos. Al igual que una bala o un misil, sólo prometerían un modo de guerra más limpio si quienes los utilizan tratan de exigirse un estándar más alto. Esa no es una idea particularmente reconfortante.

Un robot asesino con un “modo no” también podría plantear sus propios riesgos éticos. Así como los humanos no siempre darán órdenes virtuosas a las máquinas, las máquinas no siempre tendrían razón cuando se den vuelta y digan que no. Incluso cuando las armas autónomas se vuelvan muy buenas para diferenciar a los combatientes de los niños, por ejemplo, todavía a veces confundirán a uno con el otro. Es posible que no puedan tener en cuenta los factores contextuales que hacen que una orden aparentemente problemática sea legal. Las armas autónomas también pueden ser pirateadas. Como lo ha demostrado la guerra en Ucrania, por ejemplo, las técnicas para bloquear y comandar drones son sofisticadas y evolucionan rápidamente. Además, un modo no algorítmico podría ser explotado por adversarios astutos. Un ejército podría, por ejemplo, disfrazar sus posiciones de artillería con un camuflaje que engañe a un arma autónoma para que las confunda con estructuras civiles.

RELACIONADO:

Por qué un estudio engañoso del “equipo rojo” sobre la industria de la síntesis genética pone en duda erróneamente la seguridad de la industria

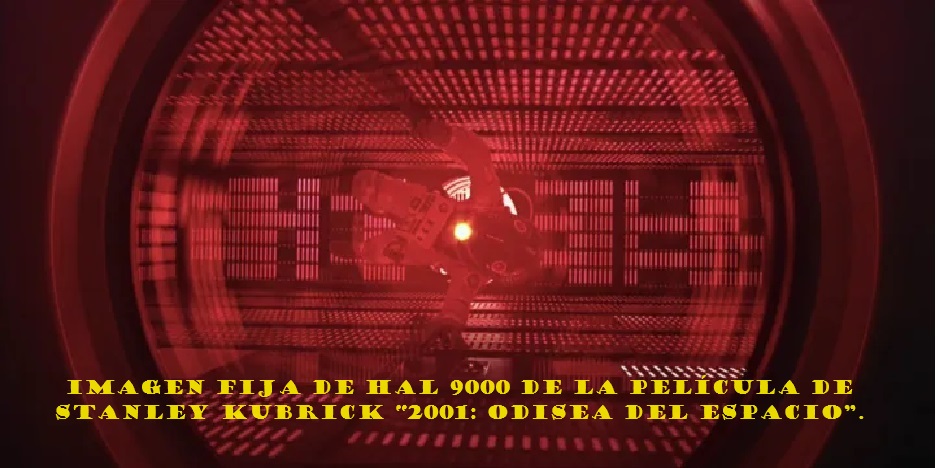

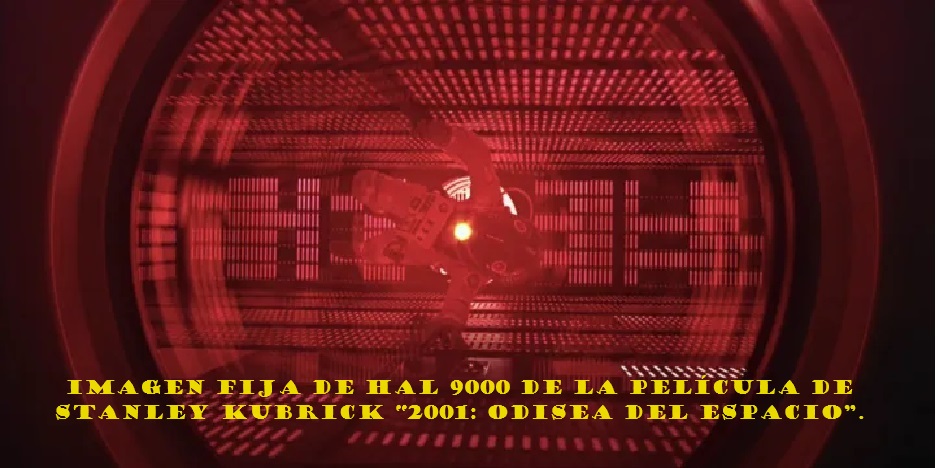

En otras palabras, en determinadas condiciones un arma podría rechazar una orden legal. Dadas las formidables capacidades de estos sistemas, ese es un riesgo inaceptable. Hay una razón por la que la parte más aterradora de 2001: Odisea del espacio es cuando la computadora, HAL 9000, se niega a cumplir las órdenes del astronauta David Bowman de dejarlo regresar a la nave, ya que hacerlo pondría en peligro la misión que le asignó el comando superior. La línea es una advertencia conmovedora para nuestros tiempos: “Lo siento, Dave, me temo que no puedo hacer eso”.

Ahí radica la paradoja. Dar a las armas autónomas la capacidad de distinguir con precisión el curso de acción correcto del incorrecto, sin sesgo ni error, se considera un criterio mínimo para permitir que estas máquinas entren en el campo de batalla. Otro criterio, la previsibilidad, sostiene que las máquinas solo deben hacer lo que sus comandantes quieren y esperan que hagan. Se supone que estos principios de la ética de la IA son compatibles con el principio fundamental del control. La realidad podría ser más complicada que eso. Los humanos quieren que las máquinas autónomas sean nobles, pero ¿pueden permitir que la máquina sea más noble que ellos y aún así decir que están a cargo?

Por supuesto, es posible que los militares encuentren una tercera vía. Por ejemplo, tal vez baste con que las armas autónomas simplemente pregunten a su comandante "¿está seguro?" antes de proceder con una orden. Los expertos en derecho internacional han argumentado que si las armas de IA pueden diseñarse para incitar a los humanos a reconsiderar sus decisiones, sin anular las órdenes en sí, podrían permitir a los militares tomar decisiones más sólidas desde el punto de vista legal en el fragor de un conflicto. Un sistema de IA podría, por ejemplo, instar a un comandante enfurecido que esté planeando un ataque aéreo apresurado en una zona densamente poblada a pensarlo dos veces, o buscar una segunda opinión humana, antes de dar una orden.